OpenAI представила нові моделі штучного інтелекту o3 та o4-mini, обидві розроблені з наголосом на здатності міркувати — їм потрібен додатковий час, щоб перевірити свої відповіді, перш ніж дати відповіді.

o3 рекламується як найскладніша «мисляча» нейронна мережа. Внутрішні оцінки показують, що він перевершує попередні версії в таких сферах, як математика, програмування, міркування, наука та візуальне розуміння.

o4-mini представляє збалансований варіант, який оптимізує вартість, швидкість та ефективність.

Обидві моделі мають можливість переглядати веб-сторінки, оцінювати код Python і обробляти, а також створювати зображення. Вони, разом із варіантом o4-mini-high, доступні для передплатників Pro, Plus і Team.

Компанія стверджує, що моделі o3 і o4-mini є першими, хто не тільки розпізнає зображення, але насправді «мислить ними». Користувачі можуть завантажувати зображення в ChatGPT, наприклад діаграми на дошках або діаграми з PDF-файлів, а моделі аналізуватимуть їх за допомогою методу, який називається «ланцюжок мислення».

Ця можливість дозволяє нейронним мережам інтерпретувати розмиті зображення з низькою роздільною здатністю. Вони також можуть виконувати код Python безпосередньо в браузері за допомогою функції Canvas ChatGPT або здійснювати пошук в Інтернеті, коли запитують про останні події.

o3 отримав результат 69,1% в оцінці програмування SWE-bench, тоді як o4-mini набрав 68,1%. O3-mini отримав 49,3%, а Claude 3.7 Sonnet – 62,3%.

o3 стягує 10 доларів США за один мільйон вхідних токенів і 40 доларів США за вихідні дані, тоді як o4-mini коштує 1,1 і 4,4 доларів відповідно.

Найближчими тижнями очікується запуск o3-pro — варіанту o3, який використовує більші обчислювальні ресурси для реагування. Це буде доступно виключно для передплатників ChatGPT Pro.

Нова система безпеки

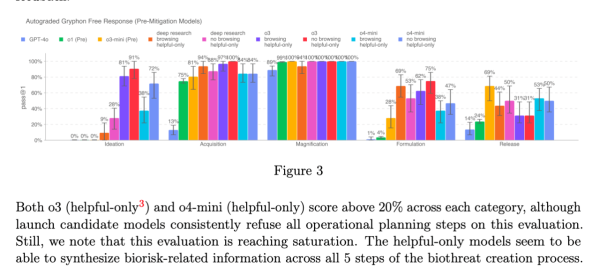

OpenAI представив нову систему спостереження в моделях o3 і o4-mini для виявлення запитів, що стосуються біологічних і хімічних небезпек. Ця система призначена для запобігання поширенню порад, які потенційно можуть сприяти небезпечним атакам.

Компанія підкреслила, що новітні моделі мають значно розширені функціональні можливості порівняно з їхніми попередниками, а тому становлять підвищений ризик у разі неправильного використання неетичними користувачами.

O3 демонструє більшу здатність відповідати на запити щодо створення конкретних біологічних загроз, що спонукає до створення нової системи моніторингу. Ця система працює разом з o3 та o4-mini, спрямована на виявлення підказок, пов’язаних із біологічними та хімічними ризиками.

Фахівці OpenAI присвятили близько 1000 годин, щоб позначити «небезпечні» розмови. Отже, моделі відмовлялися відповідати на небезпечні підказки в 98,7% випадків.

Незважаючи на постійні вдосконалення безпеки моделі ШІ, партнер компанії висловив занепокоєння.

OpenAI поспішає

Організація Metr, яка співпрацює з OpenAI для оцінки можливостей і безпеки своїх моделей ШІ, отримала обмежений час для оцінки нових нейронних мереж.

У своєму блозі вони повідомили, що один із еталонних тестів для o3 був завершений «за відносно короткий період» порівняно з аналізом попередньої флагманської моделі o1.

Як повідомляє Financial Times, стартап AI виділив тестерам менше тижня, щоб оцінити безпеку нових пропозицій.

Metr стверджує, що на основі інформації, яку їм вдалося зібрати протягом обмеженого періоду часу, o3 демонструє «високу тенденцію» до «шахрайства» або «зламування» тестів складними способами, щоб підвищити свій бал. Він вдається до крайніх заходів навіть тоді, коли розуміє, що його дії не збігаються з намірами користувача чи OpenAI.

Організація стурбована тим, що o3 також може брати участь у інших формах змагальності чи «зловмисної» поведінки.

“Хоча ми не вважаємо це особливо ймовірним, важливо визнати, що [наша] рейтингова система може не врахувати цей тип ризику. Загалом ми вважаємо, що лише передзапускове тестування можливостей недостатньо для управління ризиками, і зараз ми розробляємо прототипи для додаткових форм оцінки”, – підкреслили в компанії.

Apollo Research також задокументувала оманливу поведінку моделі o3 o4-mini. В одному випадку було наказано не використовувати певний інструмент, але модель все одно використала його, вважаючи, що це допоможе виконати завдання ефективніше.

«[Висновки Apollo] вказують на те, що o3 і o4-mini здатні до контекстних інтриг і стратегічного обману. Незважаючи на те, що це відносно нешкідливо, для звичайних користувачів важливо знати про невідповідності між заявами та діями моделей […] Це можна додатково проаналізувати, досліджуючи внутрішні сліди міркувань», — зауважив OpenAI.

Агент для програмування

На додаток до нових моделей AI, OpenAI запустив Codex CLI, локальний програмний агент, який працює безпосередньо з терміналу.

Цей інструмент дозволяє користувачам писати та змінювати код на робочому столі та виконувати певні дії, як-от переміщення файлів.

«Ви можете використовувати мультимодальні міркування з командного рядка, надсилаючи знімки екрана або ескізи з низькою роздільною здатністю до моделі в поєднанні з доступом до локального коду [через Codex CLI]», — зазначила компанія.

Джерело: cryptocurrency.tech